学習内容:

このガイドでは以下の方法を説明します:- コード内での Weave のインポートと設定

weave.opデコレータを使用したコードの追跡- Weave UI での Traces の表示

Prerequisites

- A W&B account

- Python 3.8+ or Node.js 18+

- Required packages installed:

- Python:

pip install weave openai - TypeScript:

npm install weave openai

- Python:

- An OpenAI API key set as an environment variable

新しいプロジェクトへのトレースのログ記録

コードの追跡を開始し、Weave にトレースをログ記録するには、以下の手順に従います。weaveライブラリをコードにインポートします。- コード内で

weave.init('your_wb_team/project_name')を呼び出し、トラッキング情報を W&B の Teams および Projects に送信します。チームを設定しない場合、トレースは デフォルトチーム に送信されます。指定したプロジェクトがチーム内に存在しない場合、Weave が自動的に作成します。 - 追跡したい特定の関数に

@weave.op()デコレータ を追加します。Weave はサポートされている LLM へのコールを自動的に追跡しますが、Weave デコレータを追加することで、特定の関数の入力、出力、およびコードを追跡できるようになります。TypeScript では、weave.op(your_function)という構文を使用します。

- Python

- TypeScript

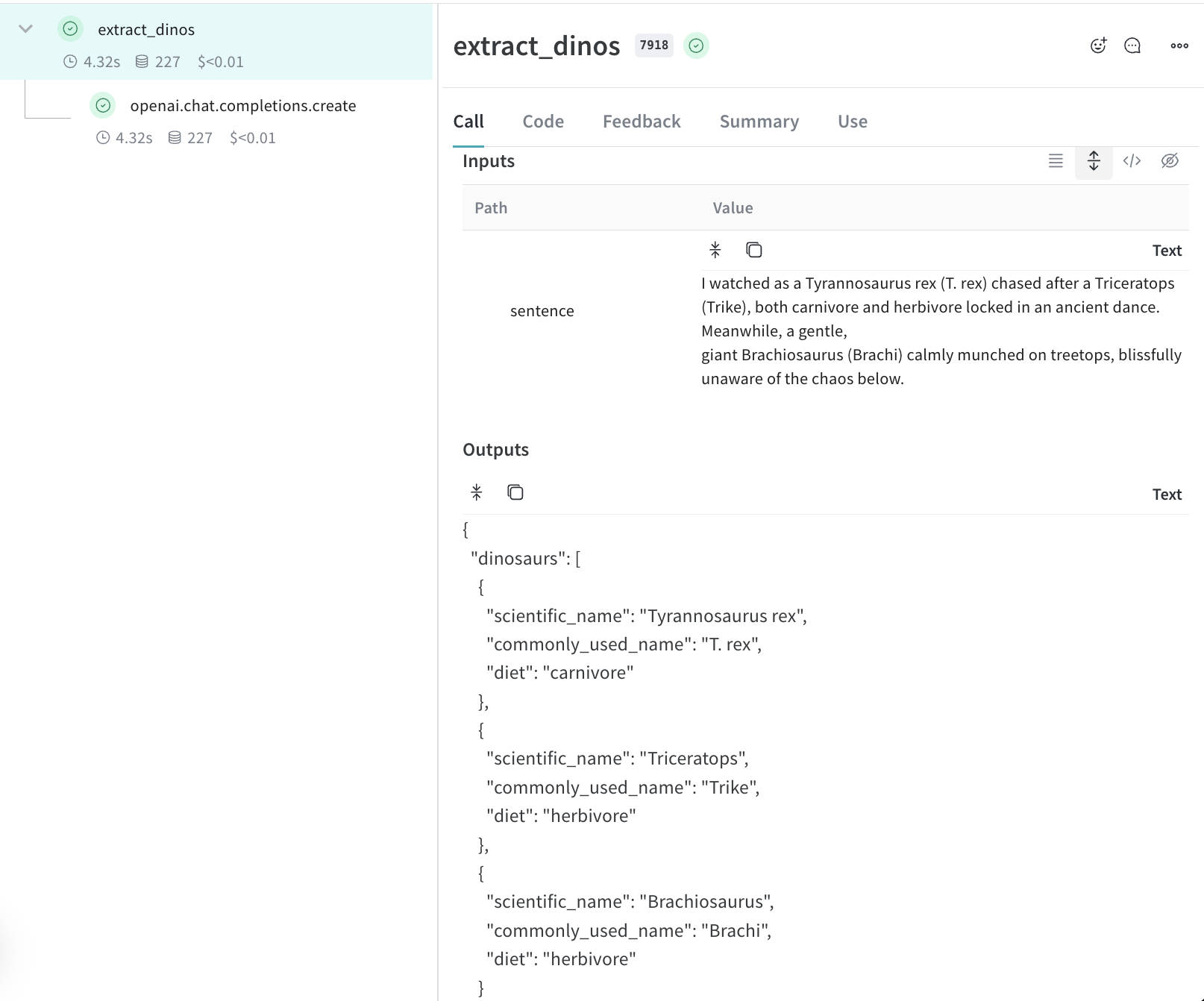

extract_dinos 関数を呼び出すと、Weave はターミナルにトレースを表示するためのリンクを出力します。出力は以下のようになります。

プロジェクト内でのアプリケーションのトレース確認

ターミナルのリンクをクリックするか、ブラウザに貼り付けて Weave UI を開きます。Weave UI の Traces パネルでトレースをクリックすると、入力、出力、レイテンシ、トークン使用量などのデータを確認できます。

Traces についての詳細

- 関数のデコレートと呼び出し情報の取得方法 について詳しく学ぶ。

- Playground を試して、ログ記録されたトレースで異なるモデルをテストする。

- インテグレーションを探索する。Weave は、OpenAI、Anthropic、その他多くの LLM ライブラリへのコールを自動的に追跡します。お使いの LLM ライブラリが現在インテグレーションに含まれていない場合でも、

@weave.op()でラップすることで、他の LLM ライブラリやフレームワークへのコールを簡単に追跡できます。