Weave を使用したモデルの評価

W&B Weave は、LLM および GenAI アプリケーションを評価するために構築された専用のツールキットです。scorer、judge、詳細なトレースなど、包括的な評価機能を提供し、モデルのパフォーマンスを理解して向上させるのに役立ちます。Weave は W&B Models と統合されており、モデルレジストリ に保存されているモデルを評価することができます。

モデル評価の主な機能

- Scorer と Judge: 正確性、関連性、コヒーレンスなどのための、事前定義済みおよびカスタムの評価メトリクス

- 評価用データセット: 体系的な評価のための正解(ground truth)を含む構造化されたテストセット

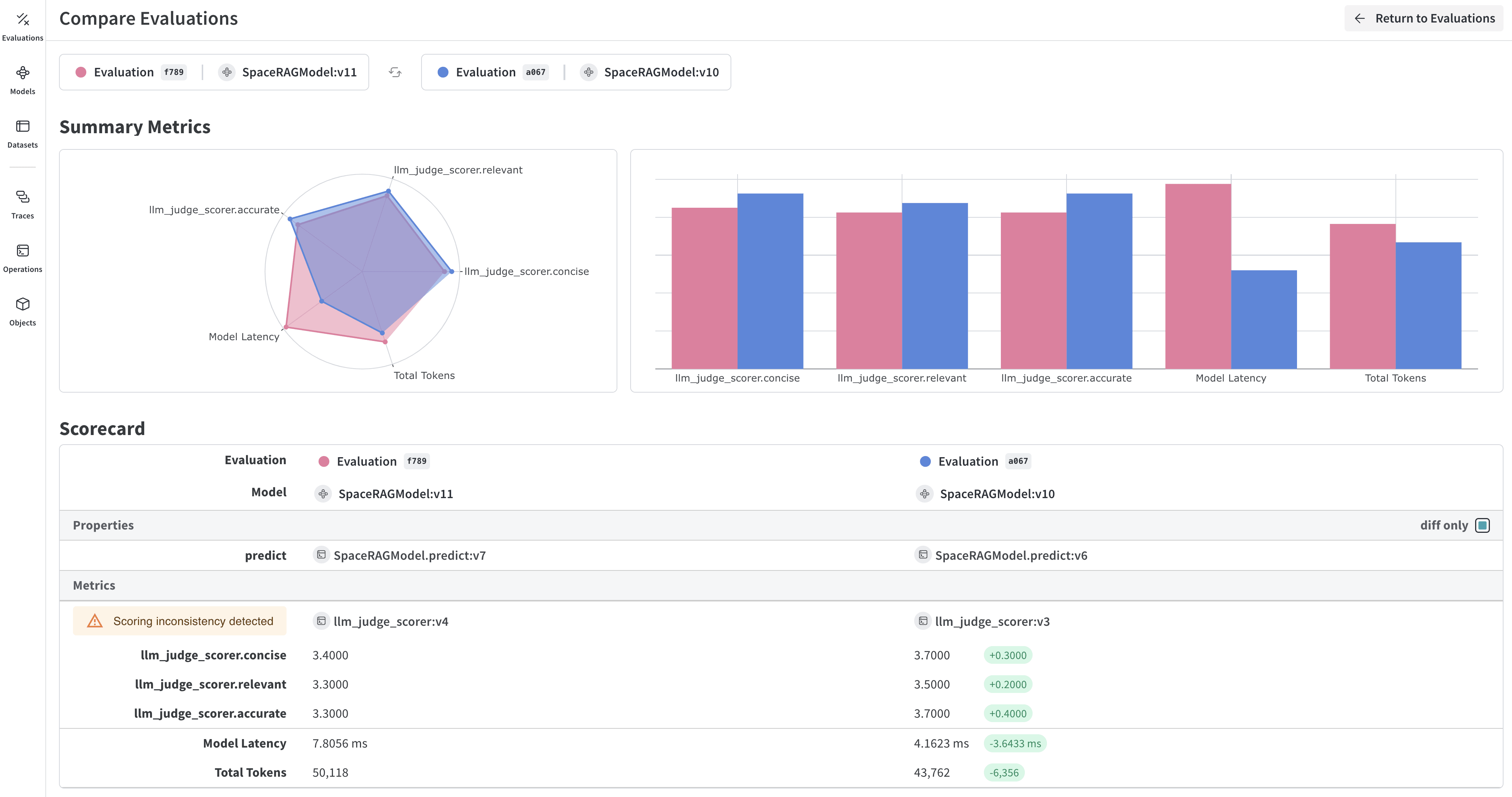

- モデルのバージョン管理: 異なるバージョンのモデルを追跡して比較

- 詳細なトレース: 完全な入力/出力トレースによりモデルの振る舞いをデバッグ

- コスト追跡: 評価全体での API コストとトークン使用量を監視

はじめに:W&B Registry からモデルを評価する

W&B Models Registry からモデルをダウンロードし、Weave を使用して評価します。Weave の評価を W&B Models と統合する

Models and Weave Integration Demo では、以下の完全なワークフローを紹介しています:- Registry からモデルをロード: W&B Models Registry に保存されたファインチューン済みモデルをダウンロード

- 評価パイプラインの作成: カスタム scorer を使用した包括的な評価を構築

- 結果を W&B にログ記録: 評価メトリクスをモデルの Runs に接続

- 評価済みモデルのバージョン管理: 改善されたモデルを Registry に保存

高度な Weave 機能

カスタム scorer と judge

ユースケースに合わせて洗練された評価メトリクスを作成します。バッチ評価

複数のモデルバージョンや設定を評価します。次のステップ

Tables を使用したモデルの評価

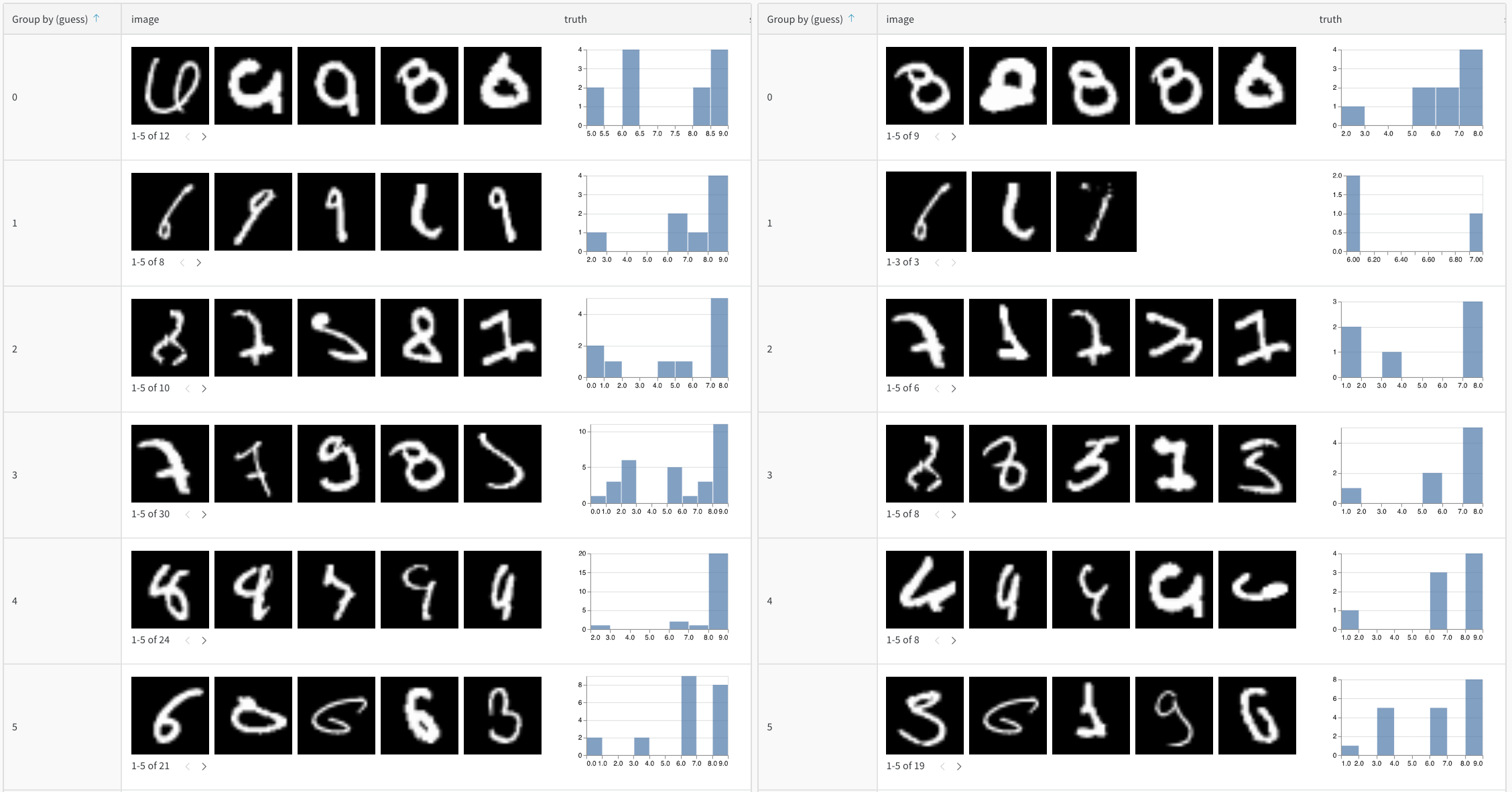

W&B Tables を使用して以下を行います:- モデル予測の比較: 同じテストセットに対して異なるモデルがどのように機能するかを並べて比較

- 予測の変化を追跡: トレーニングのエポックやモデルのバージョン間で予測がどのように進化するかを監視

- エラーの分析: フィルタリングとクエリを使用して、よくある誤分類の例やエラーパターンを特定

- リッチメディアの可視化: 予測やメトリクスとともに、画像、音声、テキスト、その他のメディアタイプを表示

基本的な例:評価結果をログ記録する

高度なテーブルワークフロー

複数のモデルを比較する

直接比較するために、異なるモデルからの評価テーブルを同じキーでログ記録します。

時間経過に伴う予測の追跡

改善を可視化するために、異なるトレーニングエポックでテーブルをログ記録します。W&B UI でのインタラクティブな分析

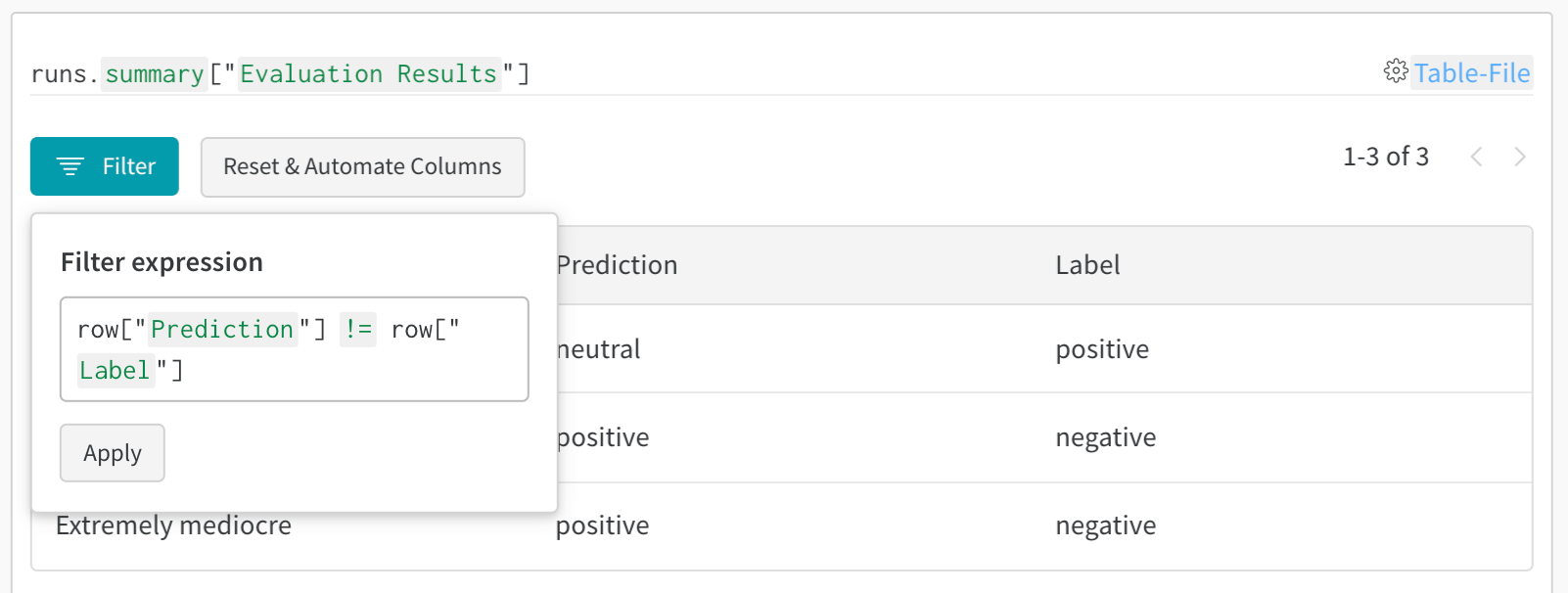

ログ記録が完了すると、以下が可能になります:- 結果のフィルタリング: 列ヘッダーをクリックして、予測精度、確信度のしきい値、または特定のクラスでフィルタリング

- テーブルの比較: 複数のテーブルバージョンを選択して、並べて比較を表示

- データのクエリ: クエリバーを使用して特定のパターンを検索(例:

"correct" = false AND "confidence" > 0.8) - グループ化と集計: 予測されたクラスでグループ化し、クラスごとの精度メトリクスを確認