新しい Mistral v1.0 SDK をサポートしています。移行ガイドについては こちら をご確認ください。

トレース

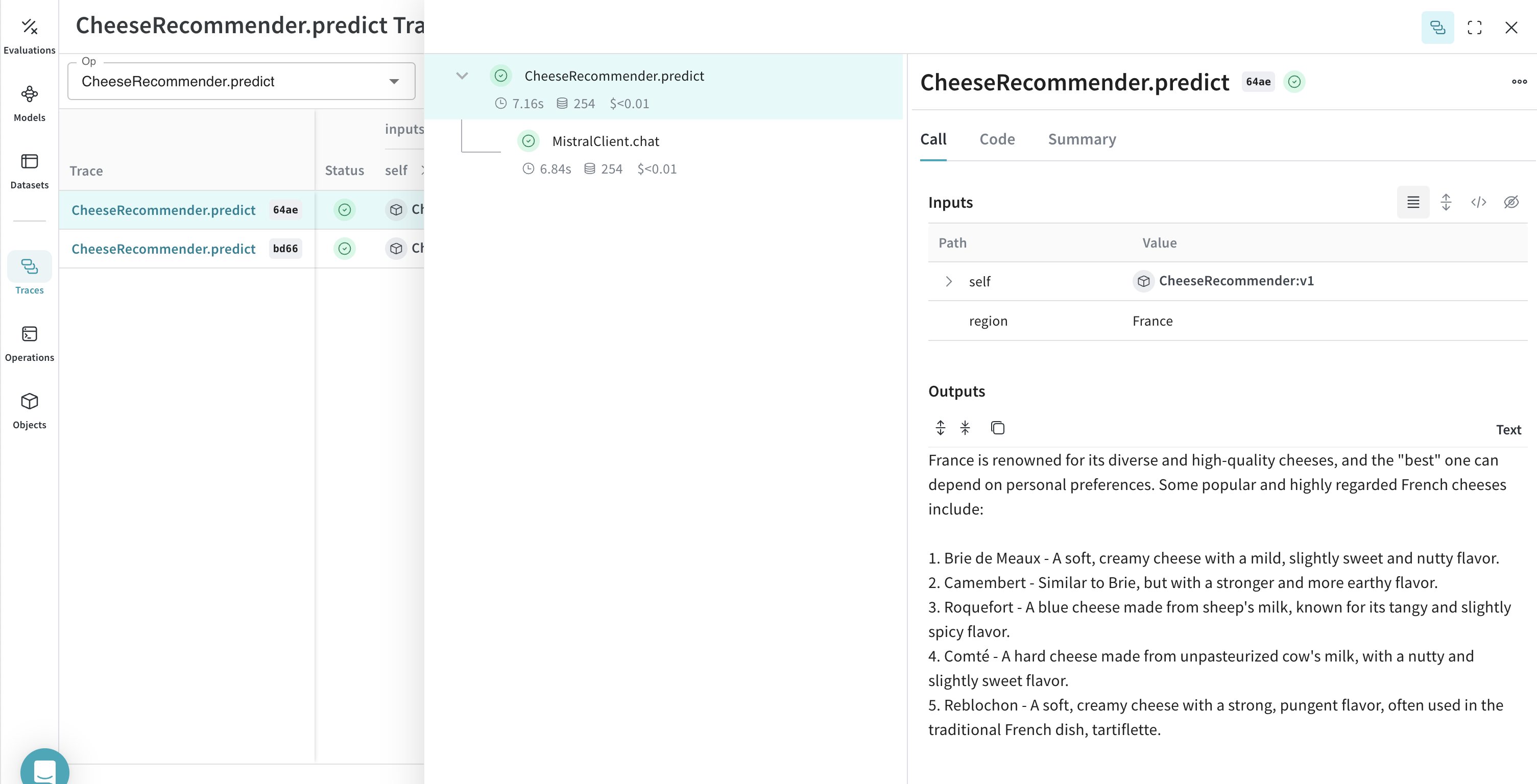

開発中および プロダクション の両方において、 LLM アプリケーション の トレース を中央データベースに保存することは重要です。これらの トレース はデバッグに使用されるだけでなく、 アプリケーション を改善するための データセット としても役立ちます。 Weave は mistralai の トレース を自動的にキャプチャします。ライブラリを通常通り使用し、まずweave.init() を呼び出すだけで開始できます。

独自の op でラップする

Weave の op は、 実験 中の コード を自動的に バージョン管理 することで 結果 の 再現性 を高め、入力と出力をキャプチャします。@weave.op() デコレータを付けた関数を作成し、その中で mistralai.client.MistralClient.chat() を呼び出すだけで、 Weave が自動的に入力と出力を追跡します。チーズレコメンダーでこれをどのように行うか見てみましょう。

より簡単な実験のために Model を作成する

多くの可動パーツがある場合、 実験 を整理するのは困難です。 Model クラスを使用すると、システムプロンプトや使用している モデル など、 アプリケーション の 実験 詳細をキャプチャして整理できます。これにより、 アプリケーション の異なる反復の整理と比較が容易になります。

コード の バージョン管理 や入出力のキャプチャに加えて、 Model は アプリケーション の 振る舞い を制御する構造化された パラメータ をキャプチャするため、どの パラメータ が最適であったかを簡単に見つけることができます。また、 Weave の Models は serve や Evaluation と併用することもできます。

以下の例では、 model や country を使って 実験 できます。これらを変更するたびに、 CheeseRecommender の新しい バージョン が作成されます。