セットアップなしで Weave 上の Groq モデルを試してみたいですか? LLM Playground をお試しください。

Tracing

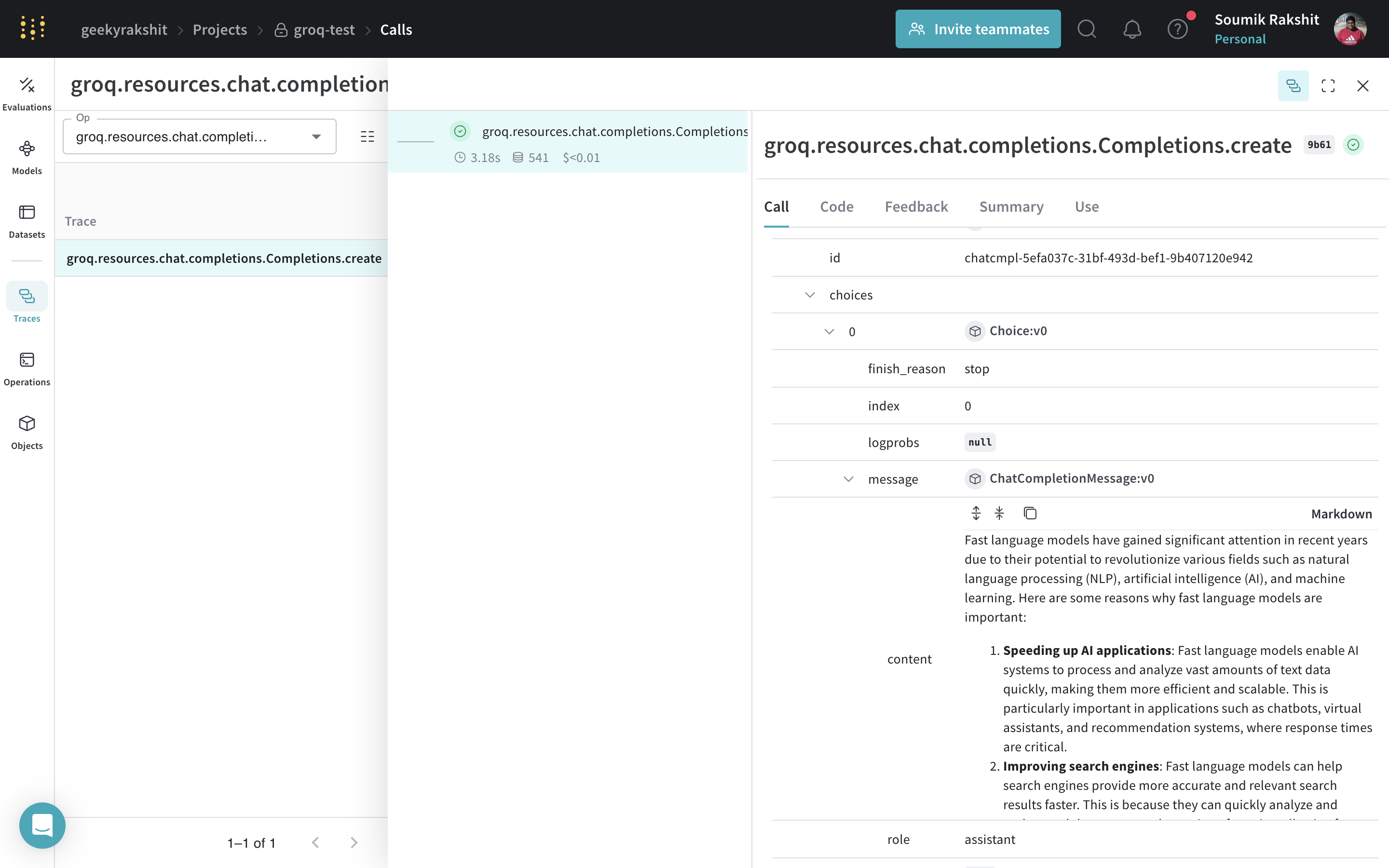

開発中および プロダクション の両方において、言語モデル アプリケーション の トレース を中央の場所に保存することは重要です。これらの トレース はデバッグに役立ち、 アプリケーション を改善するための データセット としても活用できます。 Weave は Groq の トレース を自動的にキャプチャします。追跡を開始するには、weave.init(project_name="<YOUR-WANDB-PROJECT-NAME>") を呼び出し、通常通り ライブラリ を使用してください。

|

|---|

| Weave は、 Groq ライブラリ を介して行われたすべての LLM 呼び出しを追跡し、ログを記録します。 Weave のウェブインターフェースで トレース を確認できます。 |

独自の op を追跡する

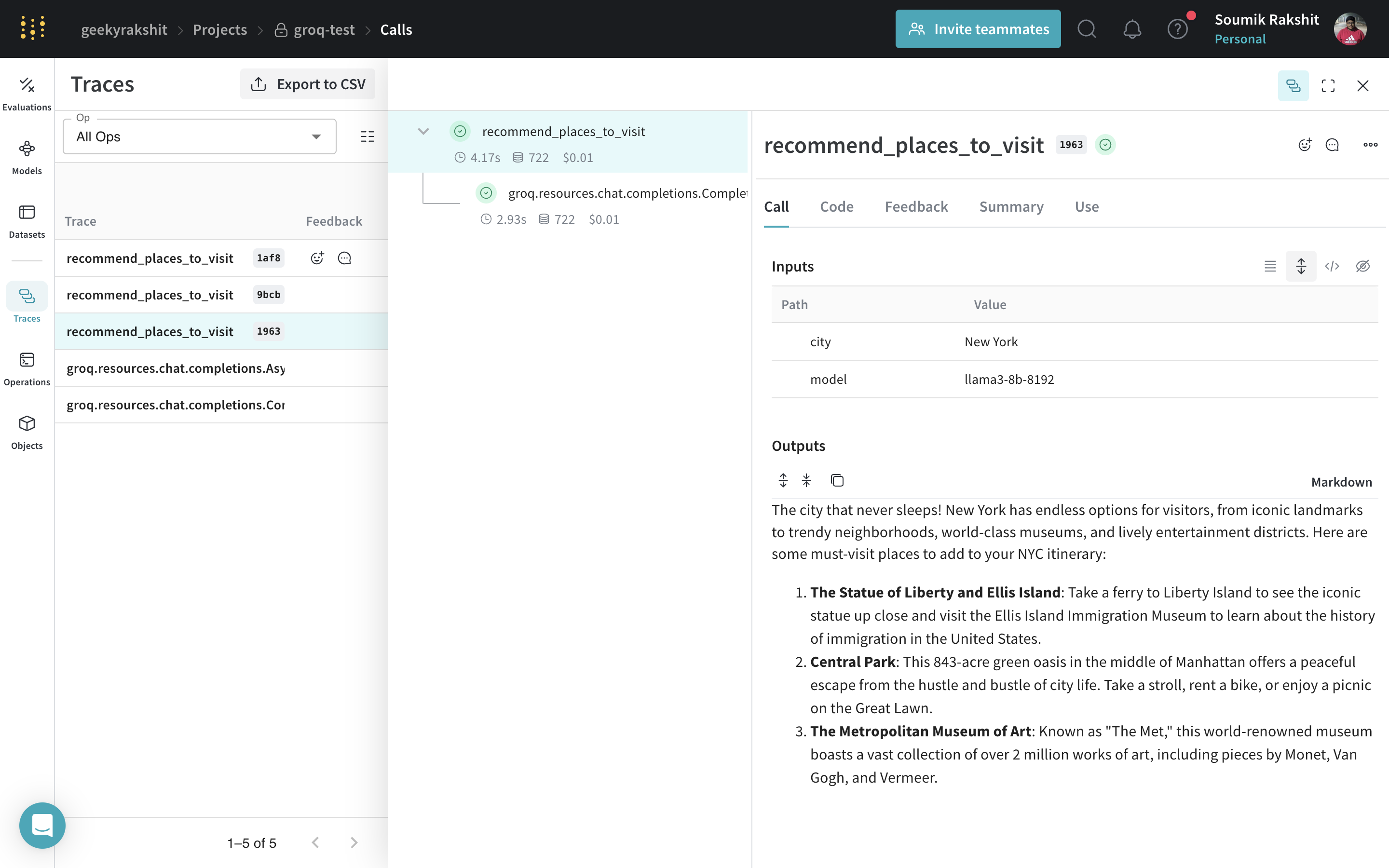

関数を@weave.op でラップすると、入力、出力、 アプリケーション ロジックのキャプチャが開始され、 アプリケーション 内でどのように データ が流れているかをデバッグできるようになります。 op を深くネストして、追跡したい関数の ツリー を構築できます。これにより、実験中に git にコミットされていないアドホックな詳細をキャプチャするために、コードの バージョン管理 も自動的に開始されます。

@weave.op でデコレートされた関数を作成するだけです。

以下の例では、 recommend_places_to_visit という関数があります。これは、都市の観光スポットを推薦する @weave.op でラップされた関数です。

|

|---|

recommend_places_to_visit 関数を @weave.op でデコレートすることで、その入力、出力、および関数内で行われたすべての内部 LM 呼び出しが トレース されます。 |

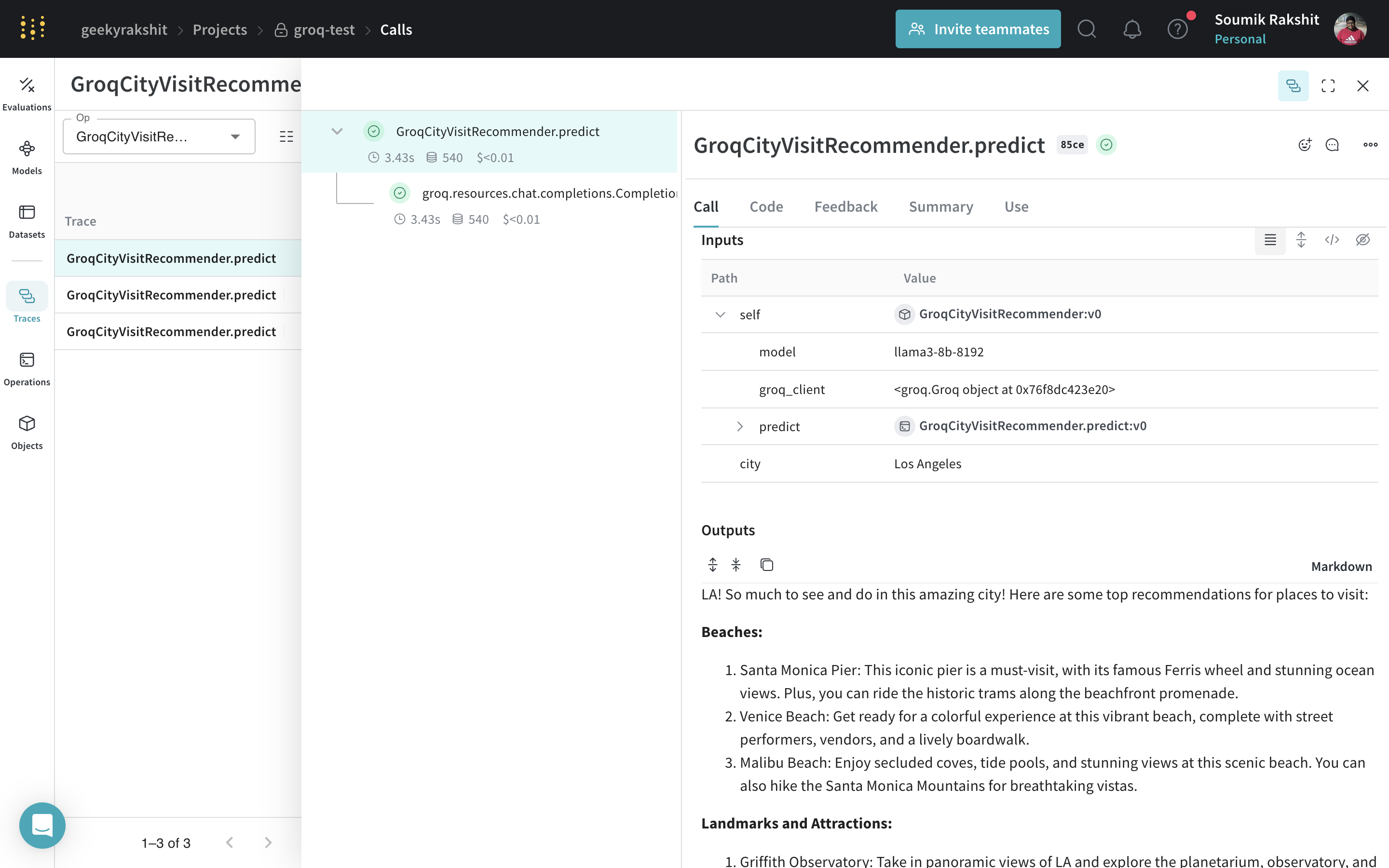

実験を容易にするための Models の作成

多くの要素が動いている場合、実験の整理は困難になります。 Models クラスを使用すると、システムプロンプトや使用している モデル など、 アプリケーション の実験的な詳細をキャプチャして整理できます。これにより、 アプリケーション の異なるイテレーションの整理や比較が容易になります。

コードの バージョン管理 や入力/出力のキャプチャに加えて、 Models は アプリケーション の 振る舞い を制御する構造化された パラメータ をキャプチャし、どの パラメータ が最適であったかを簡単に見つけられるようにします。また、 Weave Models は serve や Evaluations と併用することもできます。

以下の例では、 GroqCityVisitRecommender を使って実験ができます。これらを変更するたびに、 GroqCityVisitRecommender の新しい「バージョン」が作成されます。

|

|---|

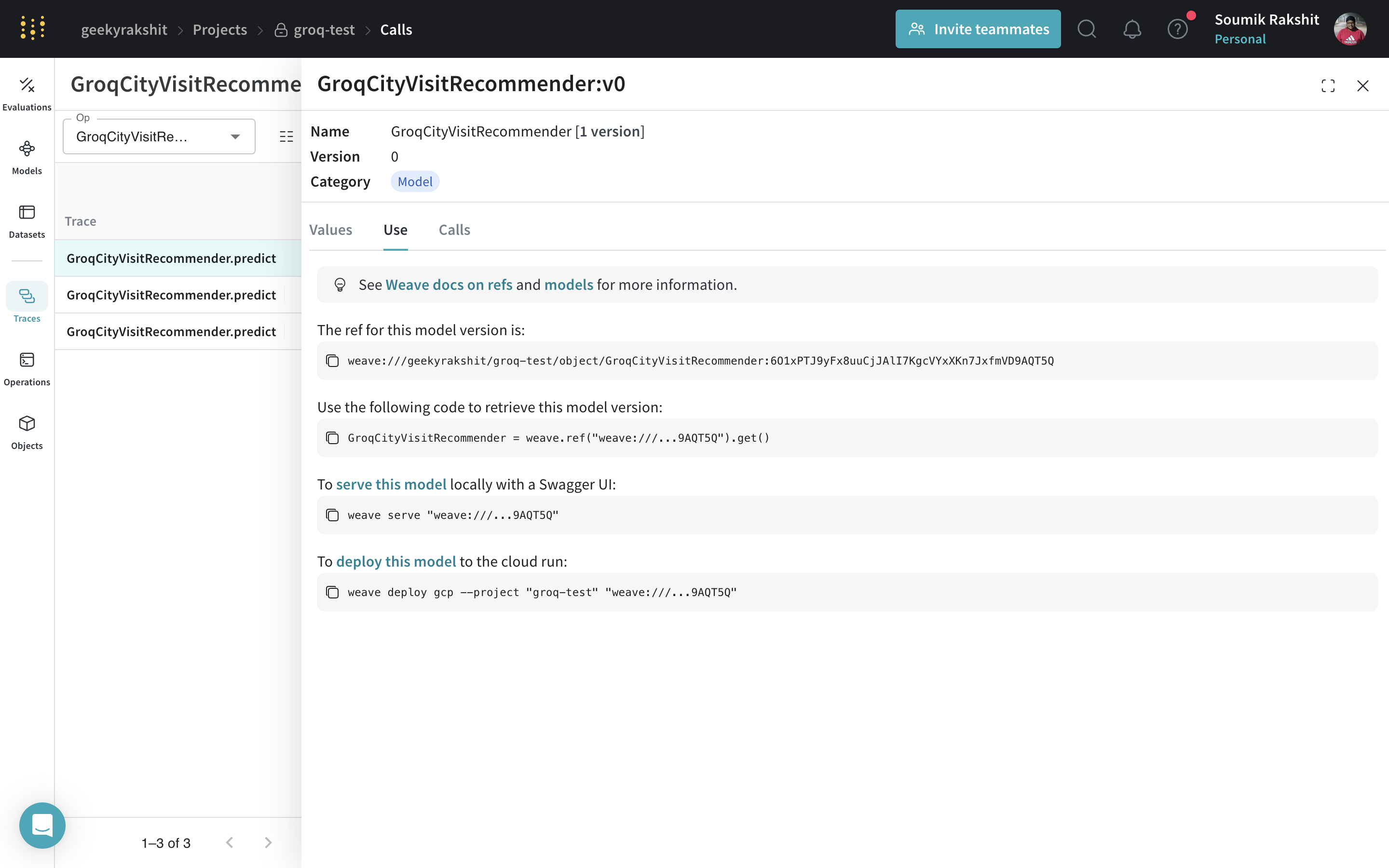

Models を使用した呼び出しの トレース と バージョン管理 |

Weave モデルのサービング

任意のweave.Model オブジェクトへの Weave リファレンスがあれば、 FastAPI サーバーを立ち上げて serve することができます。

ターミナル で以下の コマンド を使用して モデル をサービングできます。